Rancher Server 设置

- Rancher 版本:2.5.5

- 在线或离线部署:离线部署

下游集群信息

- Kubernetes 版本: v1.19.6-rancher1-1

- Cluster Type (Local/Downstream): Downstream

- 如果 Downstream,是什么类型的集群?(自定义/导入或为托管 等):

自定义集群

用户信息

- 登录用户的角色是什么? (管理员/集群所有者/集群成员/项目所有者/项目成员/自定义):

管理员

**主机操作系统:CentOS Linux release 7.9.2009 (Core)

问题描述: 无法通过修改集群yaml文件,给集群的node节点配置内存和CPU预留资源,从而避免过度使用node节点资源导致node节点宕机

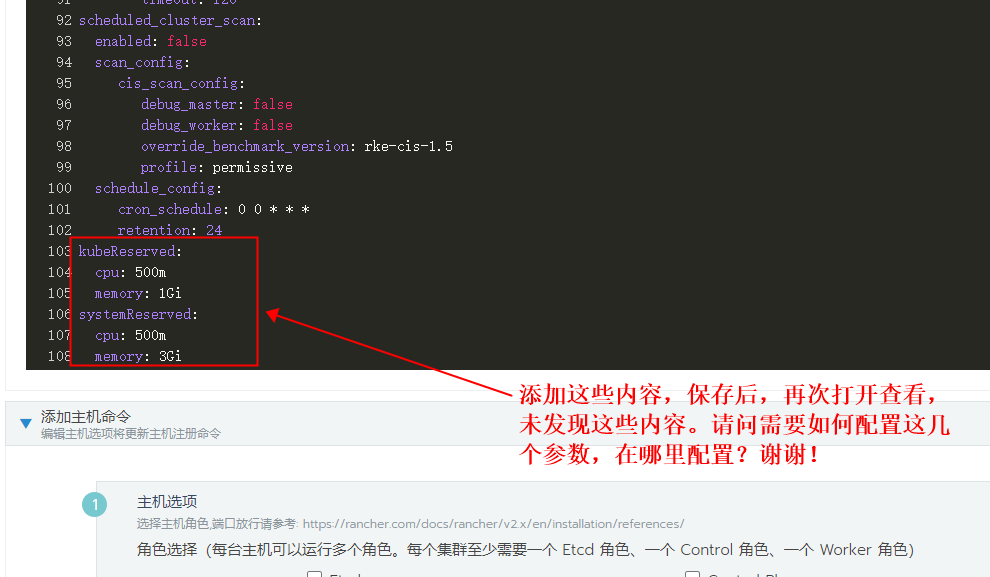

重现步骤: 编辑集群yaml,添加如下内容:

kubeReserved:

cpu: 500m

memory: 1Gi

systemReserved:

cpu: 500m

memory: 3Gi

结果: 保存并等待集群更新完成后,再次打开集群的yaml文件查看,文件中并没有刚才添加的内容。

预期结果: 希望能配置node节点的memory, cpu预留值,确保运行过程中node主机不宕机

截图:

其他上下文信息:

日志

1 个赞

ksd

2

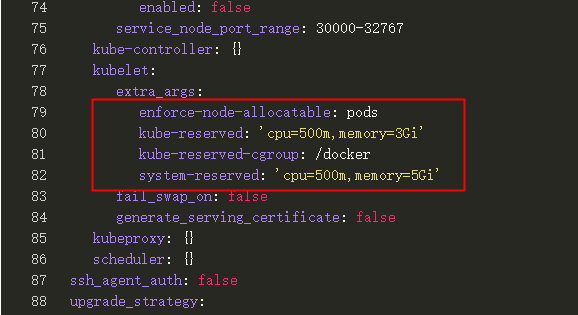

下面是一个示例,kube-reserved是 kubelet 的参数,所以在 rke 中需要加在 kubelet.extra_args 下面,参数的 key 就参考 K8s 要求的 key 即可。

rancher_kubernetes_engine_config:

services:

kubelet:

extra_args:

kube-reserved: "cpu=1,memory=2Gi"

参考:https://github.com/rancher/rancher/issues/17177

看了链接后,需要对这些参数进行配置:

kube-reserved:

system-reserved,

system-reserved-cgroup,

kube-reserved-cgroup,

eviction-hard,

enforce-node-allocatable

尝试对上面几个参数进行配置,发现下面两个参数同时使用时集群、主机异常且异常主机的kubelet一直在重启

system-reserved:

kube-reserved:

不清楚是不是cgroup与systemd之间有冲突还是什么,由于kubelet容器化,也不知如何查看kubelet使用哪种驱动,cgroup或systemd?

那如果想同时配置kube-reserved,system-reserved这两个参数,rancher 怎么配置?

就是给node节预留kube-reserved,system-reserved资源,rancher 怎么配置?

请教,给node节预留kube-reserved,system-reserved资源,rancher 怎么配置?您的这个问题是如何解决的,请教下

编译集群的yaml文件,

在kubelet下添加: system-reserved,kube-reserved