Rancher Server 设置

- Rancher 版本:

- 安装选项 (Docker install/Helm Chart):

- 如果是 Helm Chart 安装,需要提供 Local 集群的类型(RKE1, RKE2, k3s, EKS, 等)和版本:

- 在线或离线部署:

下游集群信息

- Kubernetes 版本: 1.18.20-rancher1-3

- Cluster Type (Local/Downstream): Local

- 如果 Downstream,是什么类型的集群?(自定义/导入或为托管 等):

用户信息

- 登录用户的角色是什么? (管理员/集群所有者/集群成员/项目所有者/项目成员/自定义):

主机操作系统:Ubuntu 18.04.6

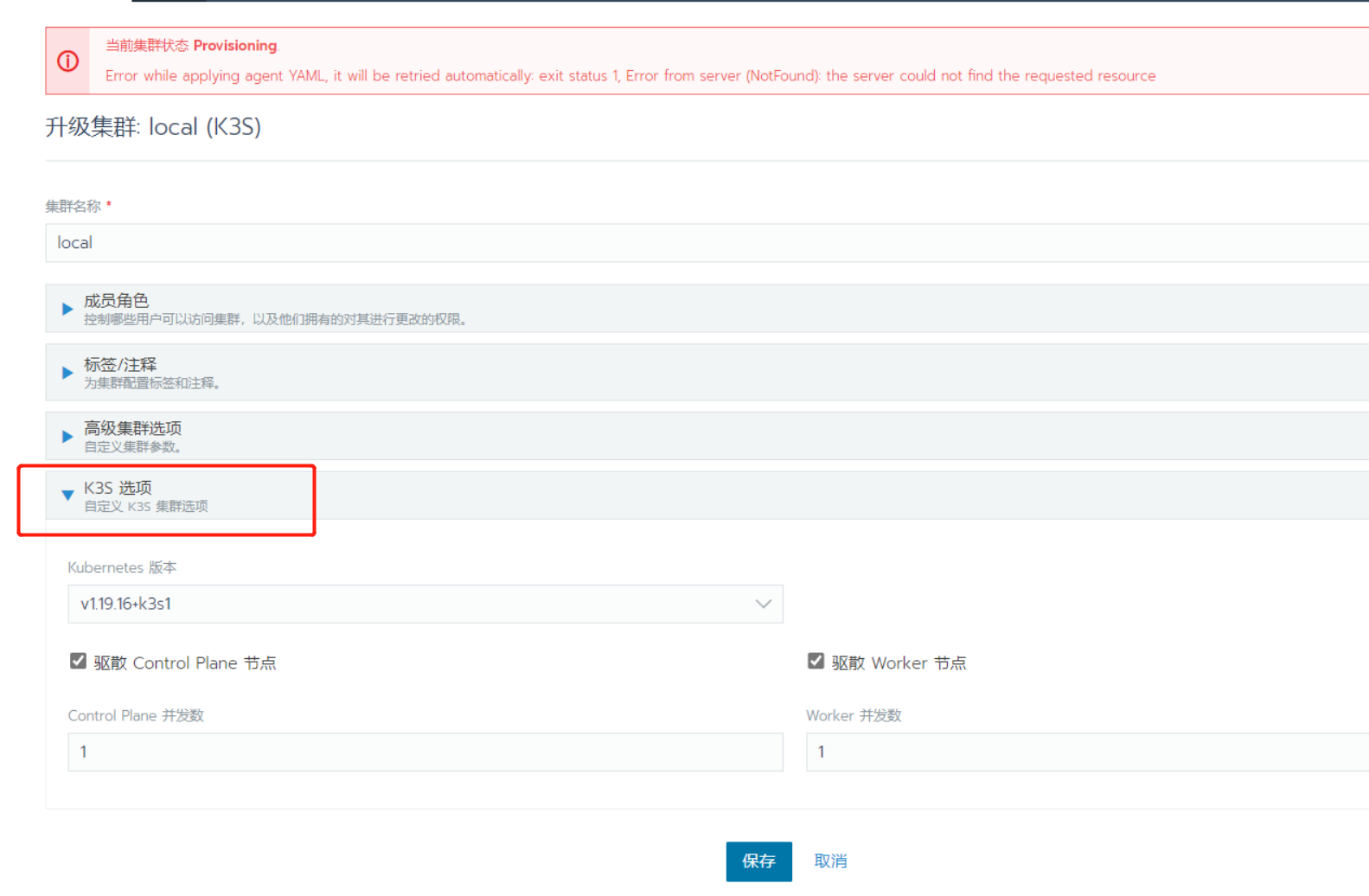

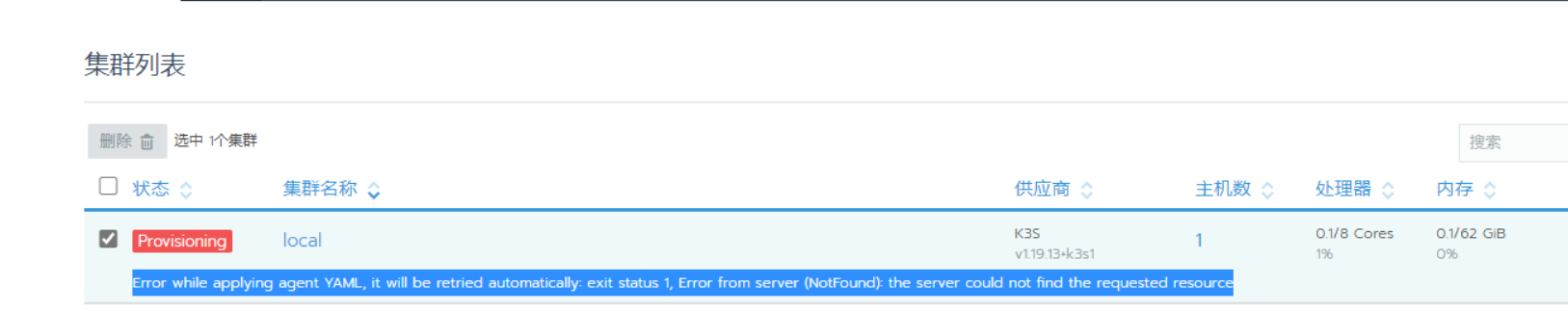

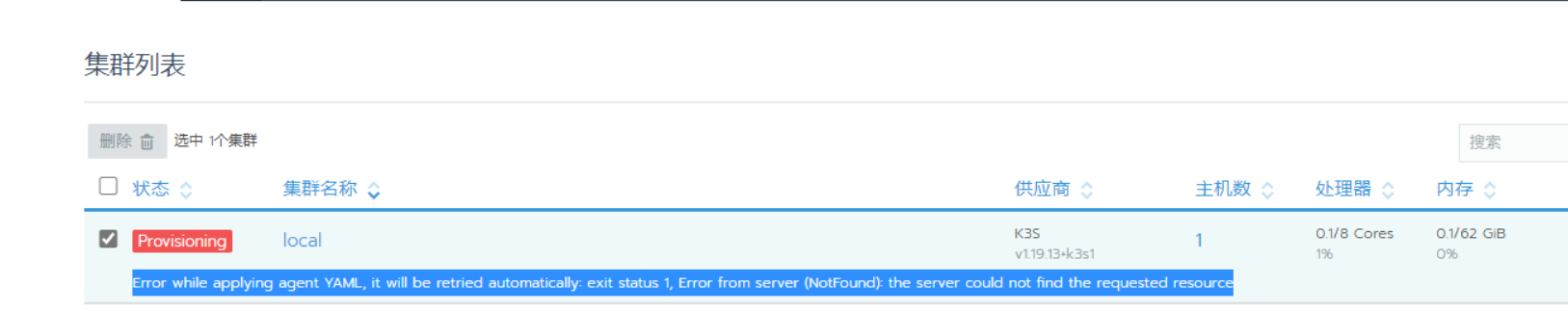

问题描述:rancher2.4.6 升级K8S版本,从17.X升级到18.x,local集群显示异常,提示

Error while applying agent YAML, it will be retried automatically: exit status 1, Error from server (NotFound): the server could not find the requested resource

重现步骤:

结果:再次升级rancher2.4.6到2.4.15,问题仍然存在

预期结果:

**截图:

**

其他上下文信息:

日志

我不清楚你是如何部署Rancher的,因为你没有在帖子中写明,即使问题中询问了安装选项和部署模式,你也没有给出说明。

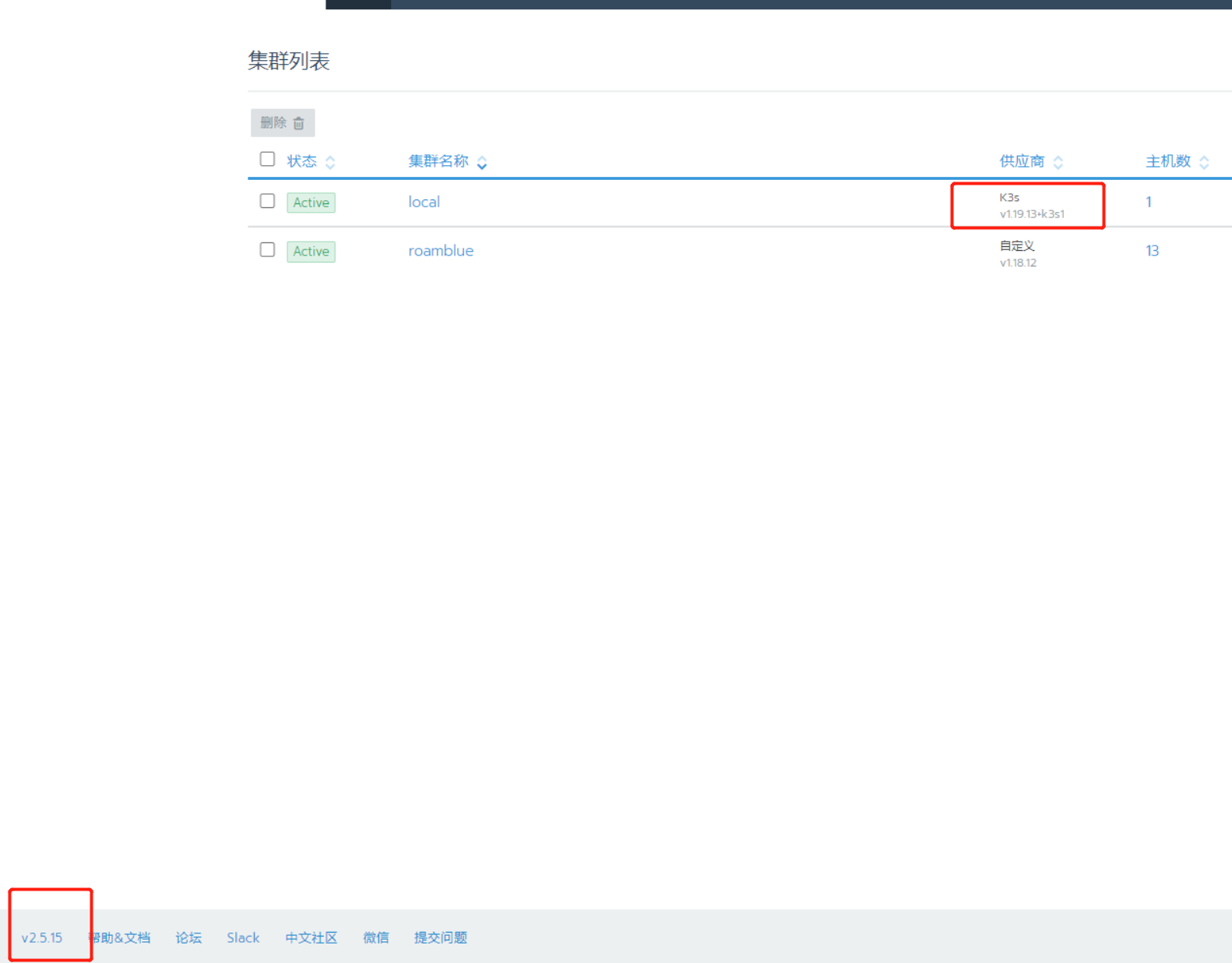

从你的截图中,可以看到一个问题:你使用的是2.4版本,它的支持矩阵最高只能支持到k8s 1.18(文档中应该有非常多的地方注明),但是local集群的版本是1.19。我怀疑是兼容问题造成的。

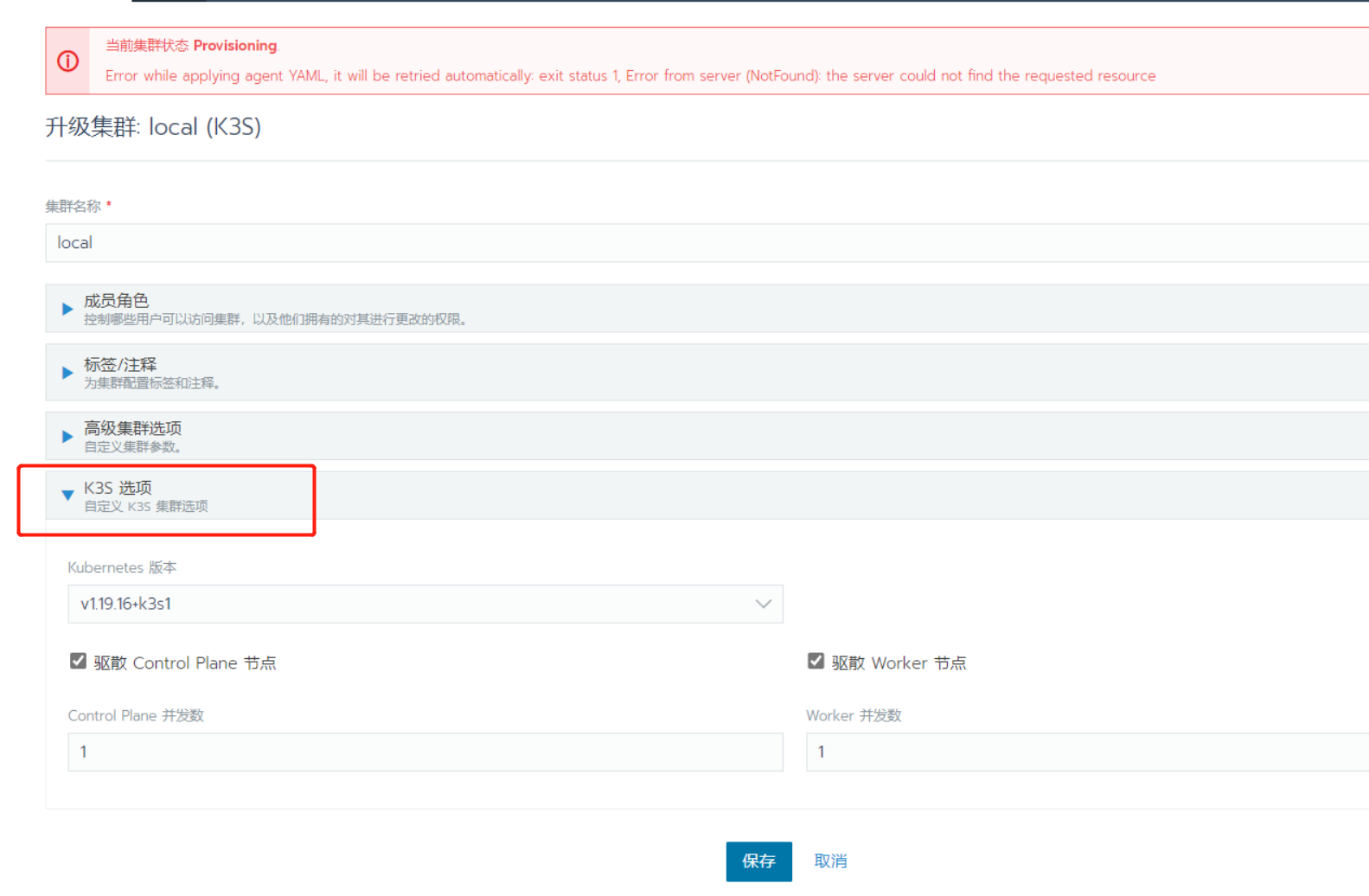

小楠你好,我进行问题的补充,rancher2.4.6版本是单节点部署的,使用现有节点创建自定义(Custom)集群方式,昨天升级的过程是先升级业务集群K8S版本到1.18.X,然后继续升级rancher到2.4.16,版本,发现local集群异常,然后编辑local集群,将K8S升级到了1.18.X,还是有问题,最后升级到1.19.X,问题仍然存在,最后我将rancher升级到2.5.15版本,还是不行。

发现local集群异常,然后编辑local集群,将K8S升级到了1.18.X,还是有问题,最后升级到1.19.X

通常,Local集群不应该这么操作升级。这个编辑操作更多面向下游集群。并且,1.19和2.4并不兼容。

现在rancher是2.5.15版本了,如果是兼容性的问题,我只能通过回滚的方式恢复吗?

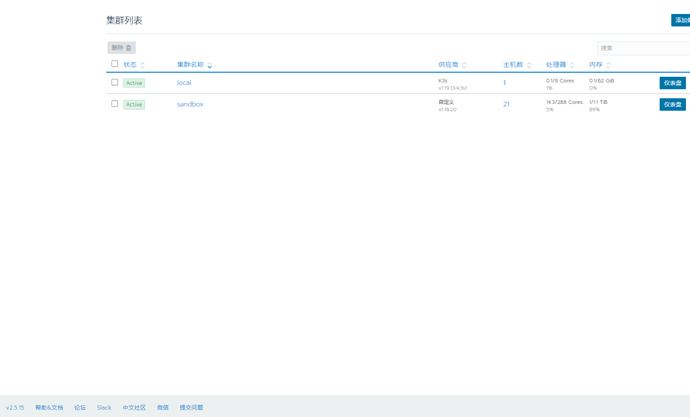

我的测试环境没有问题,生产环境升级反而出现了问题,一下图片是测试环境。

这个操作流程存在一些对于Rancher来说不期望的行为,我无法给出标准解答。

你可以尝试查看local集群的全部Pod,尤其是kube-system/cattle-system下的Pod,是否有一些部署不正常。

另一种恢复方式,可能就是在local集群中编辑一些特殊的CRD,这些操作风险很大,并不是标准方案。

我看到local集群所有NS下的pod均正常,唯独结群也显示一行警告信息,我担心会不会存在潜在的风险。

我看到现在local集群中多了一个K3S的选项,这个在测试环境中是没有的。